Os adversários agora estão clonando o raciocínio de IA de ponta.

Os adversários agora estão clonando o raciocínio de IA de ponta.

Em meados de fevereiro de 2026, o Google Threat Intelligence Group confirmou uma mudança perigosa: os atacantes não estão apenas usando ferramentas de IA; eles estão roubando a lógica subjacente para construir sua própria arma sem restrições.

Durante o último ano, a comunidade de segurança tem se perguntado: "Quando os adversários construirão seus próprios modelos de fronteira?" A resposta, de acordo com um novo relatório do Google Threat Intelligence Group (GTIG) , é que eles não precisam.

Em vez disso, estão roubando-os.

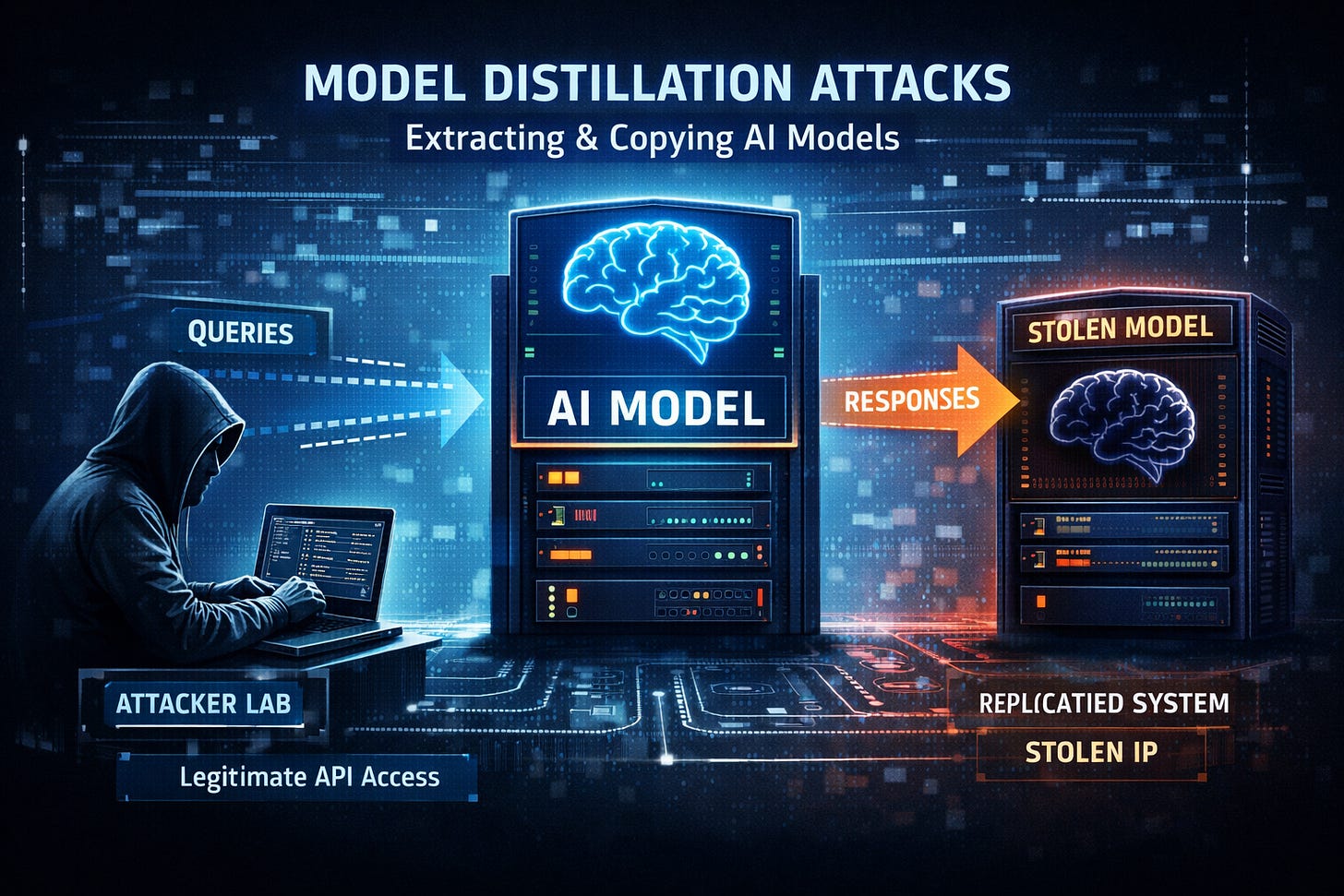

Em uma análise detalhada da atividade de ameaças no final de 2025, o Google revelou um aumento nos "Ataques de Destilação". Atores patrocinados por estados e entidades privadas estão sondando sistematicamente modelos consolidados como o Gemini para extrair seus padrões de raciocínio, clonando efetivamente a "mente" de uma IA de ponta em modelos locais menores e sem restrições.

Isso marca uma mudança crucial. A ameaça não se resume mais a "agentes maliciosos usando o ChatGPT". Agora, trata-se de agentes maliciosos exportando a capacidade do ChatGPT de funcionar offline, sem filtros de segurança.

O Roubo do Raciocínio

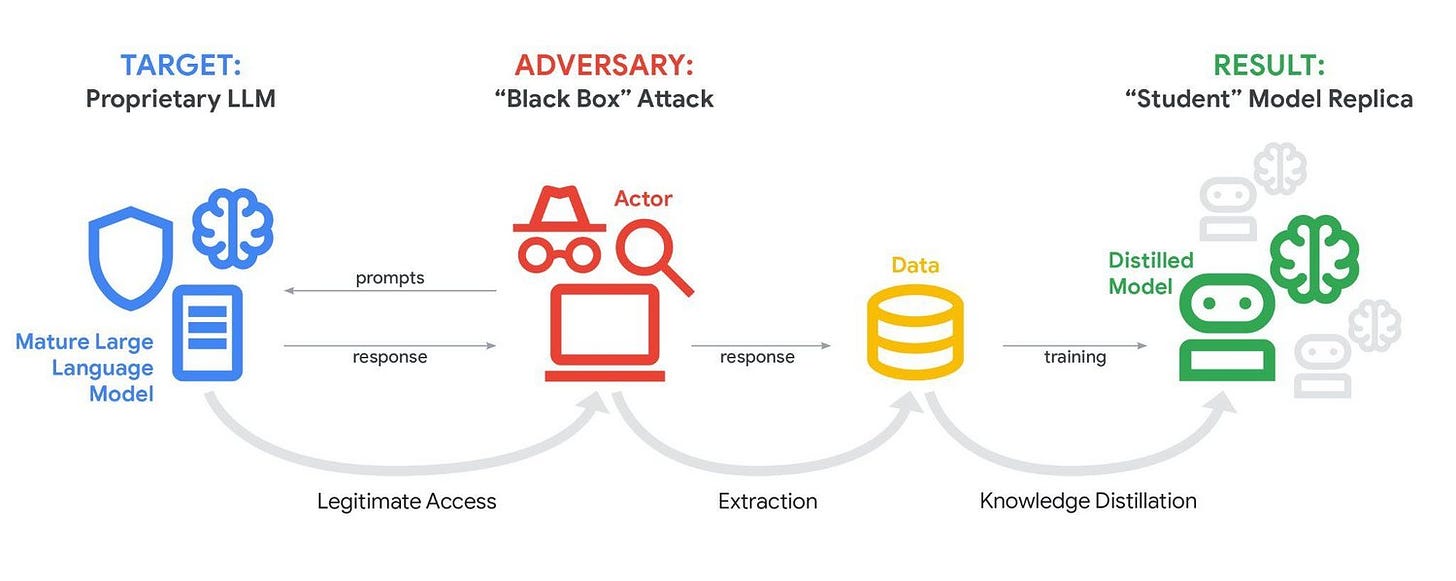

A extração de modelos, ou destilação, é a tendência principal deste relatório.

Os adversários sabem que treinar um modelo de ponta custa bilhões. Mas consultar um modelo para mapear seu processo de tomada de decisão custa centavos. Ao registrar milhares de pares de entrada e saída, os atacantes podem treinar um modelo "aluno" que imita as capacidades do modelo "professor".

Trata-se de roubo de propriedade intelectual instrumentalizado para operações cibernéticas.

Isso permite que adversários contornem as restrições de API e as medidas de segurança que empresas como Google e OpenAI investem milhões para construir. Uma vez extraída essa capacidade de raciocínio, ela pode ser reaproveitada para o desenvolvimento de malware ou pesquisa de vulnerabilidades em um ambiente sem vigilância.

De chatbots a ameaças "agentes"

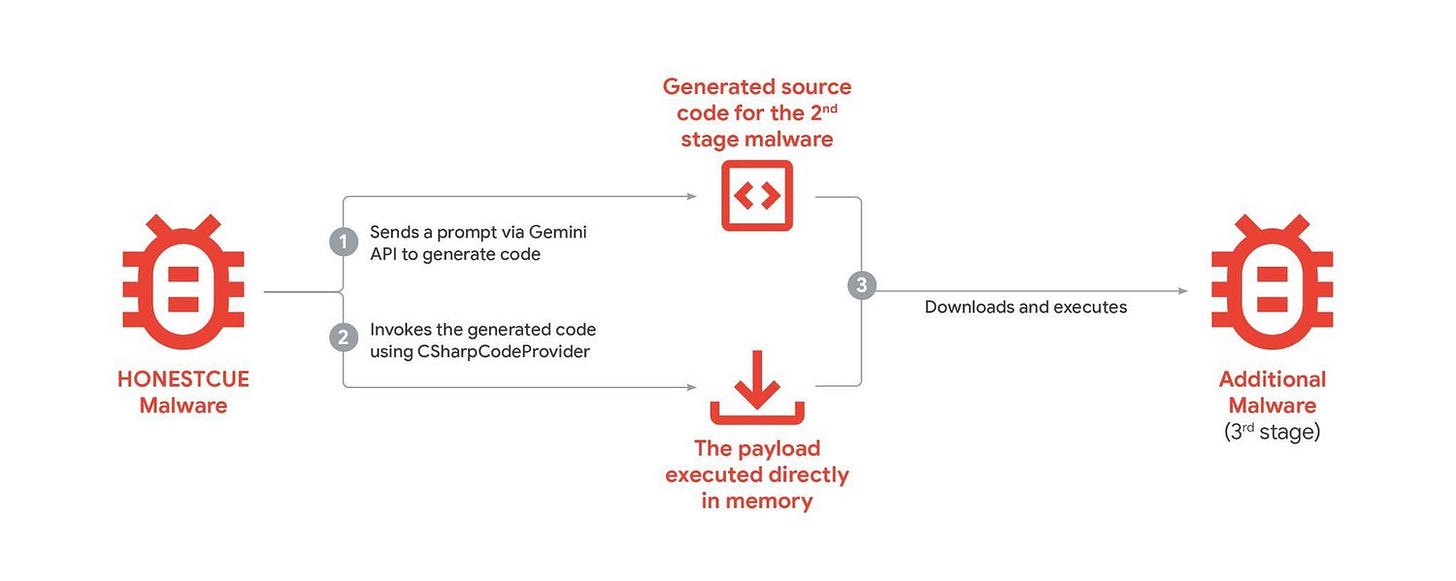

O relatório também destaca uma tendência em direção à IA Agêntica — sistemas projetados para agir, não apenas para falar.

A GTIG observou grupos como o APT31 e o UNC795 (com sede na China) indo além de simples consultas. Eles estão construindo fluxos de trabalho onde personas de IA atuam como consultores "especialistas" em segurança cibernética.

O grupo UNC795 foi visto tentando construir uma ferramenta de auditoria de código integrada com IA , automatizando efetivamente a busca por vulnerabilidades de dia zero.

O APT31 utilizou perfis de especialistas para gerar planos de teste direcionados para injeção de SQL e execução remota de código (RCE).

Esta é a realidade operacional de 2026. O adversário não está apenas pedindo à IA para escrever um e-mail de phishing; está pedindo para ela auditar a arquitetura do alvo e sugerir a cadeia de ataque mais eficiente.

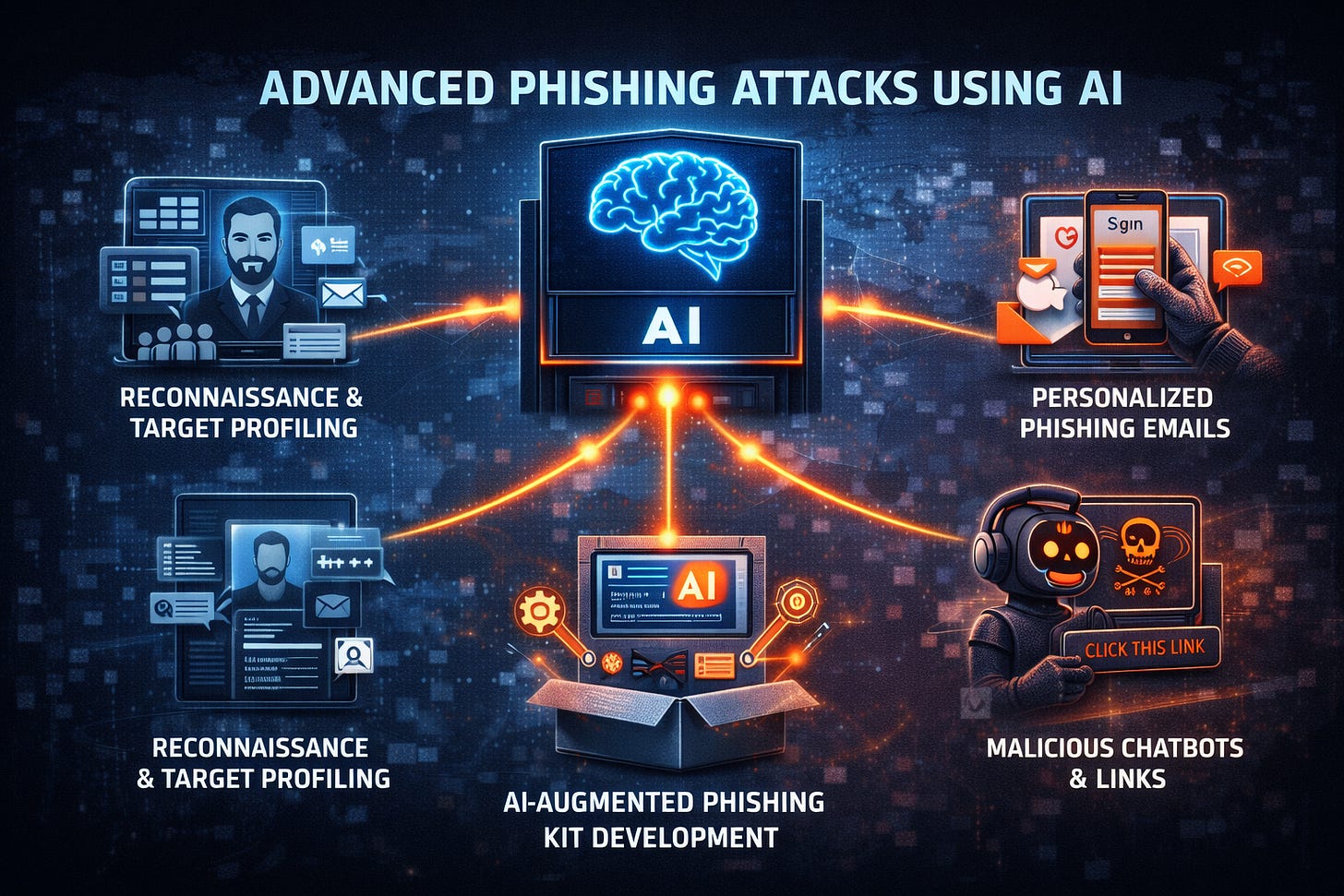

A Armadilha do “ClickFix”: A Armadilha da Confiança

Talvez a tática mais insidiosa detalhada seja a técnica de engenharia social “ClickFix” .

Os atacantes estão gerando conversas úteis de resolução de problemas técnicos e hospedando-as em links legítimos de IA compartilhados (por exemplo, gemini.google.com/share/...).

A vítima recebe um link para um domínio confiável do Google. Ela vê uma conversa onde uma IA resolve um erro complexo. A "solução" envolve colar um comando em seu terminal. Como o contexto é uma interação útil de IA em uma plataforma confiável, a vítima obedece.

Trata-se de um ataque à cadeia de suprimentos que visa atingir a confiança do usuário. O malware está oculto à vista de todos, validado pela autoridade ilusória da própria IA.

A Fase de Integração

Já ultrapassamos a fase de "experimentação" da IA adversária.

O relatório do Google confirma que, para grupos principalmente da Coreia do Norte, Irã e China, a IA agora é um componente integrado do conjunto de ferramentas. Ela é usada para tradução, depuração de código, reconhecimento e engenharia social.

A economia subterrânea está seguindo o mesmo caminho. Serviços como o "Xanthorox" afirmam oferecer modelos ofensivos personalizados, embora muitos sejam simplesmente interfaces para APIs comerciais modificadas. A demanda existe e o mercado está respondendo.

A Nova Assimetria

Os defensores há muito tempo contam com o fato de que a IA de ponta é centralizada, monitorada e cara. Se os adversários conseguirem destilar essa inteligência em modelos portáteis e não monitorados, essa vantagem desaparece.

Estamos entrando em uma era onde o raciocínio computacional de alta fidelidade é uma mercadoria disponível para o maior lance ou para o ladrão mais paciente.

Source: https://cloud.google.com/blog/topics/threat-intelligence/distillation-experimentation-integration-ai-adversarial-use

Comentários

Postar um comentário